Objetivo y problema

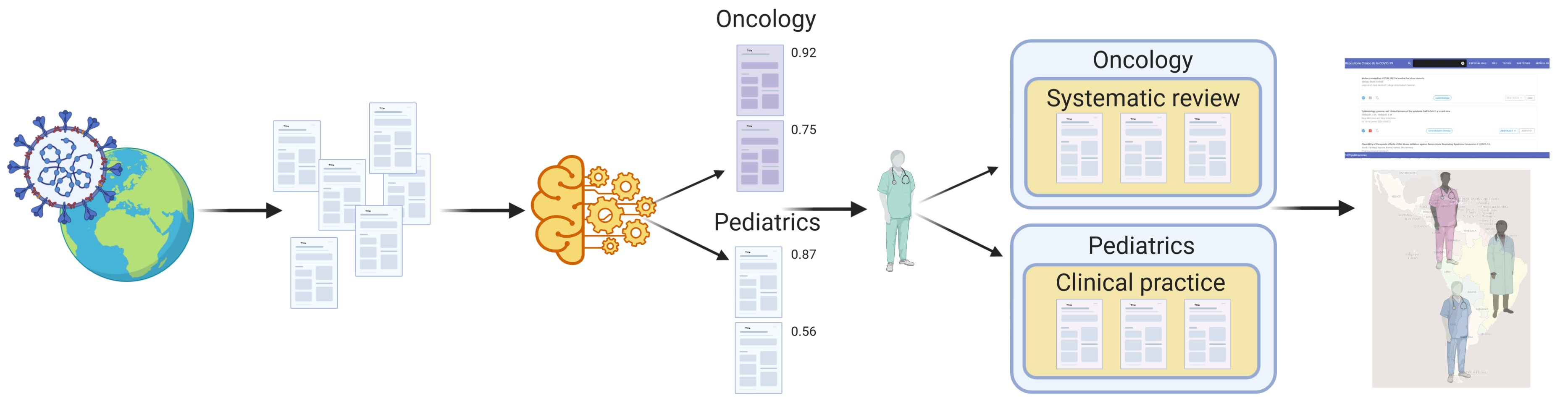

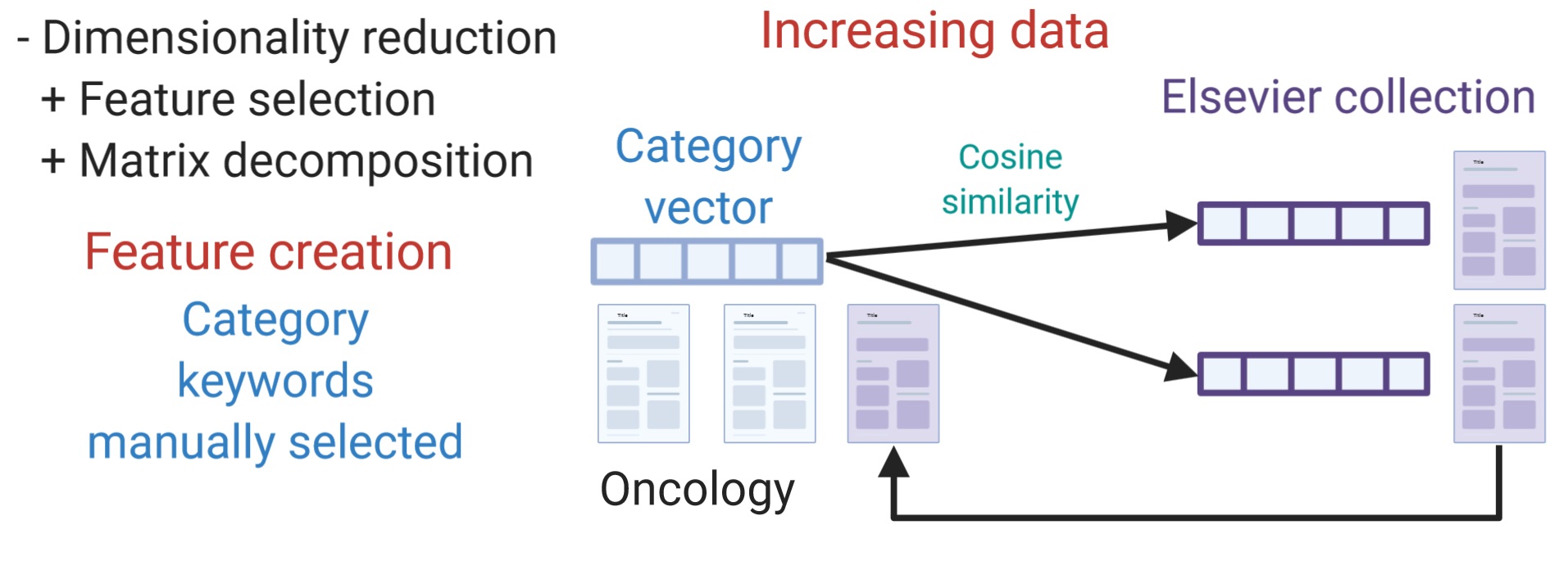

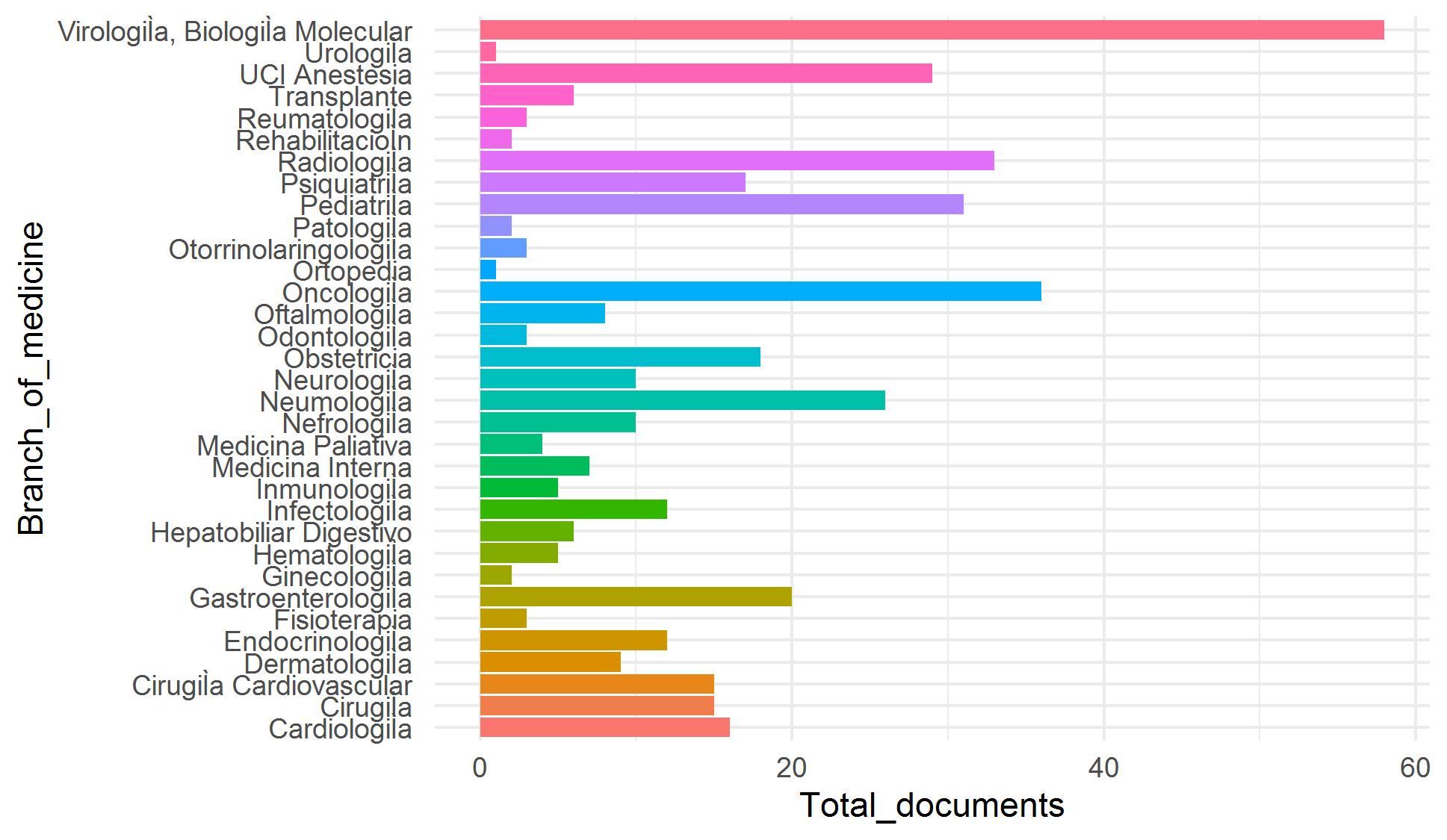

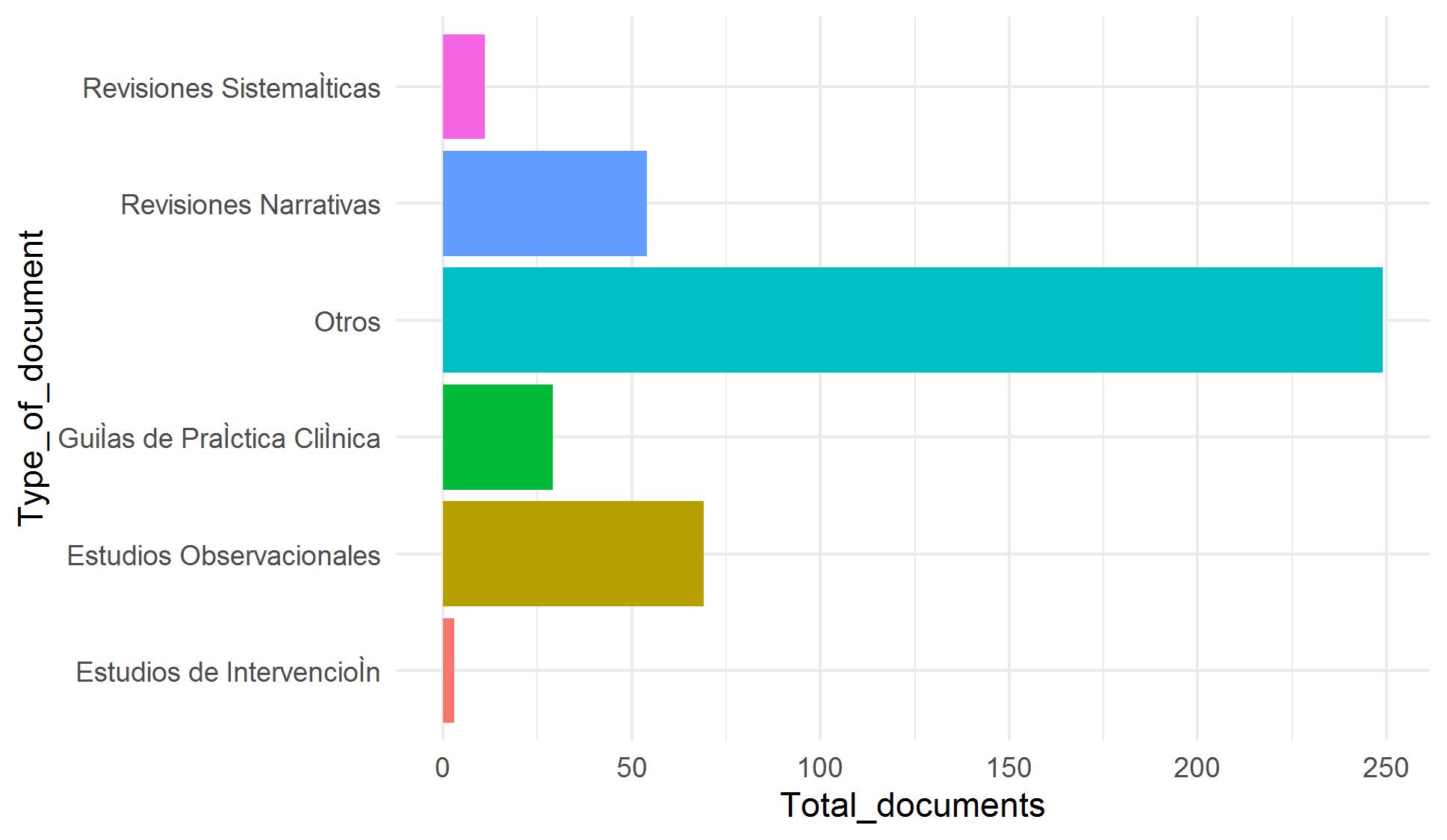

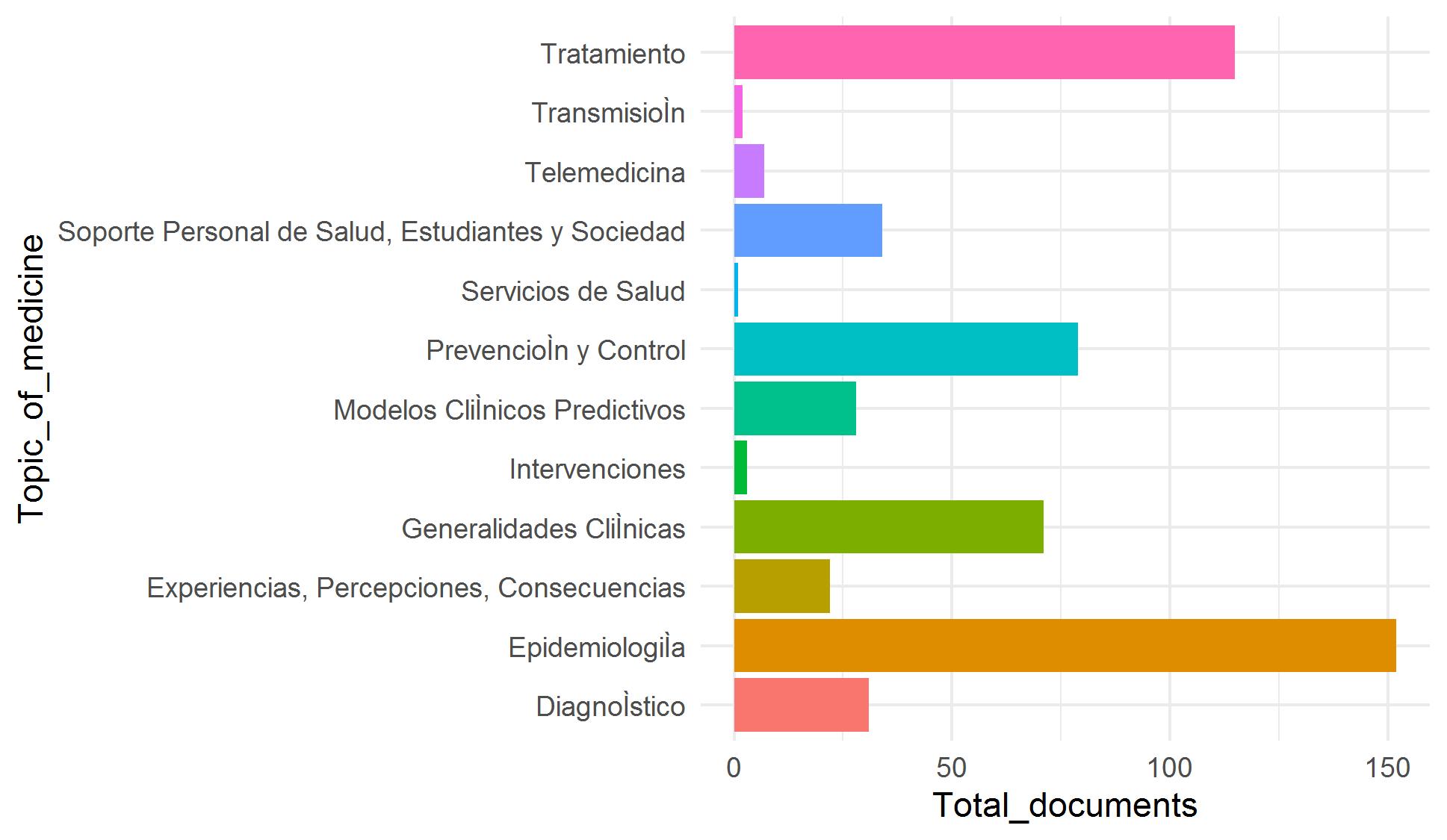

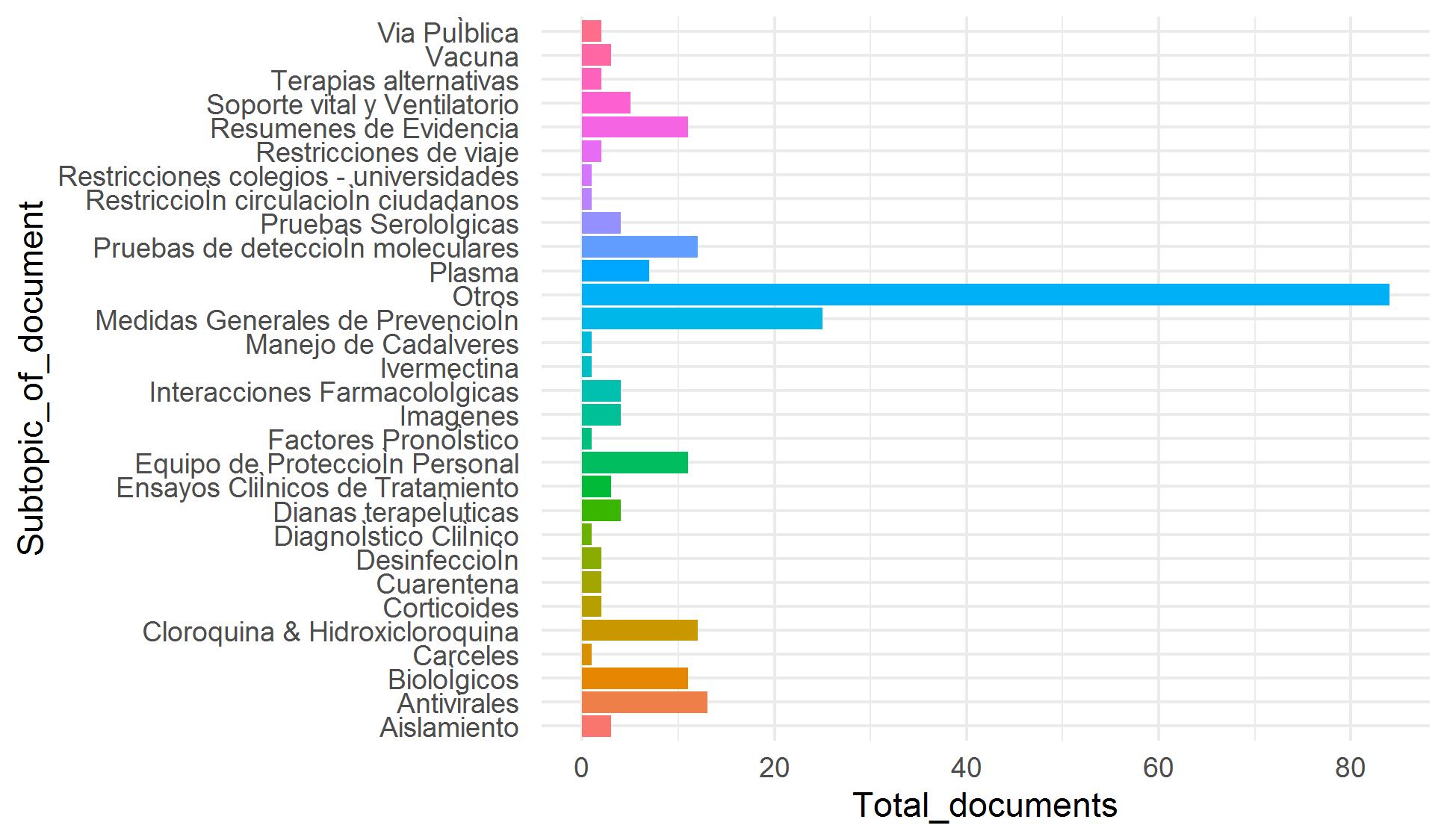

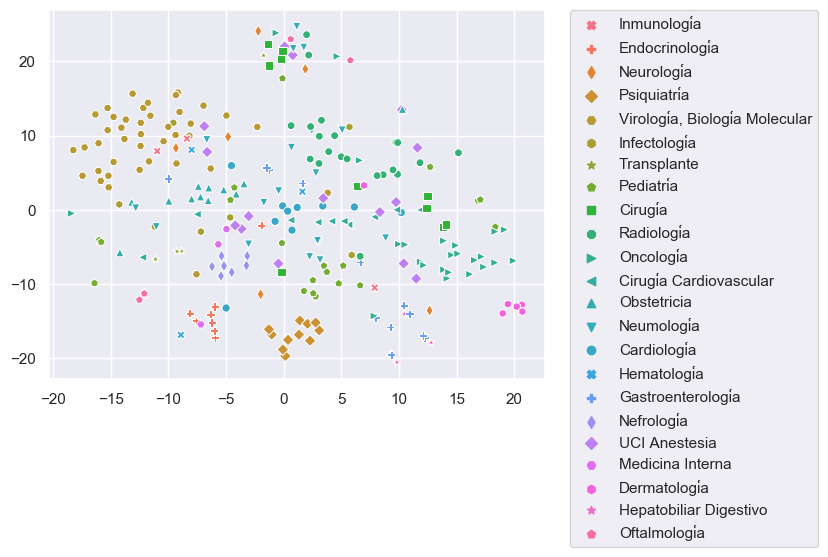

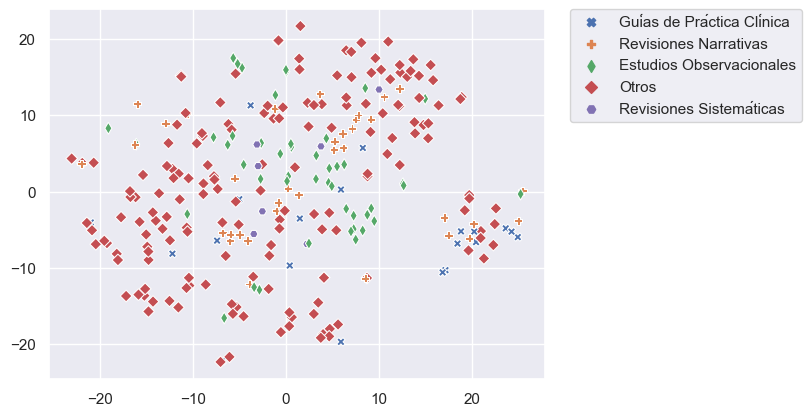

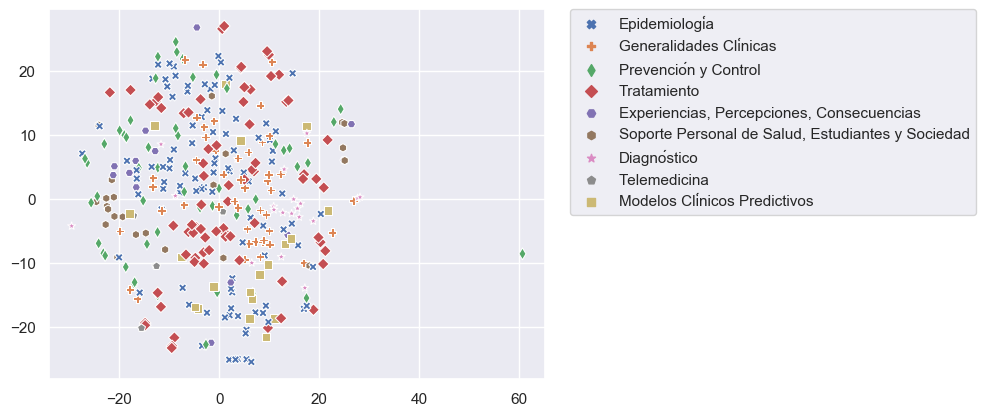

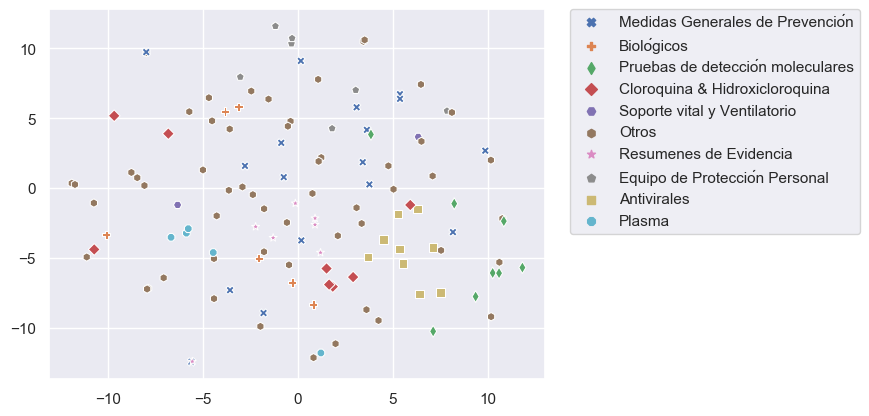

Nuestro objetivo es incorporar miles de artículos de las colecciones de Elsevier y LitCovid a nuestro repositorio COVID-19. Debido a que la clasificación manual de estos artículos es demandante y requiere mucho tiempo, hemos trabajado en una estrategia de clasificación asistida utilizando técnicas de aprendizaje supervisado y utilizando artículos clasificados manualmente como datos de entrenamiento. Nos enfrentamos a cuatro problemas para lograr este objetivo: pocos datos de entrenamiento y clases desequilibradas (categorías con pocos ejemplos) (Figura 1), categorías con datos traslapados (especialmente para Tema) (Figura 2) y alta dimensionalidad (pocas filas y muchas columnas).

|

|

|

|

|

|

|

|

|

|

|

|